前段时间,浙大&微软发布了一个大模型协作系统HuggingGPT直接爆火。

研究者提出了用ChatGPT作为控制器,连接HuggingFace社区中的各种AI模型,完成多模态复杂任务。

整个过程,只需要做的是:用自然语言将你的需求输出。

英伟达科学家称,这是我本周读到的最有意思的论文。它的思想非常接近我之前说的「Everything App」,即万物皆App,被AI直接读取信息。

现在,HuggingGPT增加了Gradio演示

项目地址:microsoft/JARVIS: JARVIS (github.com)

测试地址: HuggingGPT - a Hugging Face Space by microsoft

研究者指出解决大型语言模型(LLMs)当前的问题,可能是迈向AGI的第一步,也是关键的一步。

为了处理复杂的人工智能任务,LLMs应该能够与外部模型协调,以利用它们的能力。

因此,关键点在于如何选择合适的中间件来桥接LLMs和AI模型。

在这篇研究论文中,研究者提出在HuggingGPT中语言是通用的接口。其工作流程主要分为四步:

论文地址:https://arxiv.org/pdf/2303.17580.pdf

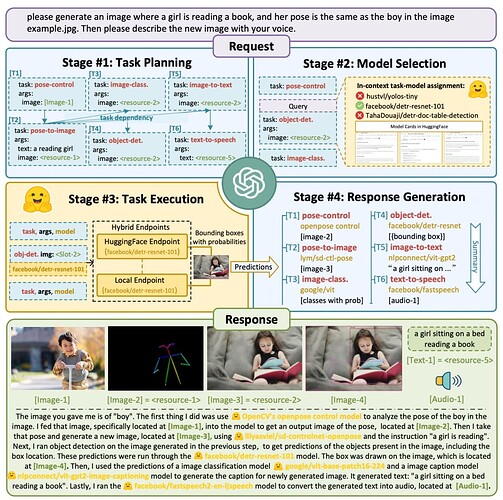

首先是任务规划,ChatGPT解析用户请求,将其分解为多个任务,并根据其知识规划任务顺序和依赖关系。

接着,进行模型选择。LLM根据HuggingFace中的模型描述将解析后的任务分配给专家模型。

然后执行任务。专家模型在推理端点上执行分配的任务,并将执行信息和推理结果记录到LLM中。

最后是响应生成。LLM总结执行过程日志和推理结果,并将摘要返回给用户。

假如给出这样一个请求:

请生成一个女孩正在看书的图片,她的姿势与example.jpg中的男孩相同。然后请用你的声音描述新图片。

可以看到HuggingGPT是如何将它拆解为6个子任务,并分别选定模型执行得到最终结果的

通过将AI模型描述纳入提示中,ChatGPT可以被视为管理人工智能模型的大脑。因此,这一方法可以让ChatGPT能够调用外部模型,来解决实际任务。

简单来讲,HuggingGPT是一个协作系统,并非是大模型。

它的作用就是连接ChatGPT和HuggingFace,进而处理不同模态的输入,并解决众多复杂的人工智能任务。

所以,HuggingFace社区中的每个AI模型,在HuggingGPT库中都有相应的模型描述,并将其融合到提示中以建立与ChatGPT的连接。

随后,HuggingGPT将ChatGPT作为大脑来确定问题的答案。

到目前为止,HuggingGPT已经围绕ChatGPT在HuggingFace上集成了数百个模型,涵盖了文本分类、目标检测、语义分割、图像生成、问答、文本到语音、文本到视频等24个任务。

实验结果证明,HuggingGPT可以在各种形式的复杂任务上表现出良好的性能。